Некероване навчання

Некеро́ване навча́ння,[1][2][3][4] неконтрольо́ване навча́ння,[5][6] навча́ння без на́гляду,[7] навча́ння без учи́теля[8] (англ. unsupervised learning) — це парадигма машинного навчання, в якій, на відміну від керованого та напівкерованого навчання, алгоритми навчаються образів виключно з немічених даних.

Завдання нейронних мереж часто класифікують як розрізнювальні (англ. discriminative, розпізнавання) та породжувальні (англ. generative, уявляння). Часто, але не завжди, розрізнювальні завдання використовують керовані методи, а породжувальні — некеровані (див. діаграму Венна); проте цей поділ дуже розмитий. Наприклад, розпізнавання об'єктів надає перевагу керованому навчанню, але некероване навчання також може кластерувати об'єкти в групи. Крім того, в міру прогресу деякі завдання застосовують обидва методи, а деякі переходять від одного до іншого. Наприклад, розпізнавання зображень розпочалося як сильно кероване, але стало гібридним, застосувавши некероване попереднє навчання, а потім знову перейшло до керованості з появою виключення, випрямляча та адаптивних темпів навчання.

Під час фази тренування некерована мережа намагається імітувати дані, які їй дають, і використовує похибку у своєму імітованому виході, щоб виправляти себе (себто виправляти свої ваги та зміщення). Іноді похибку виражають як низьку ймовірність видавання помилкового виходу, або це може бути виражено як нестабільний високоенергетичний стан у мережі.

На відміну до переважного використання в керованих методах зворотного поширення, некероване навчання також використовує й інші методи, зокрема: гопфілдове правило навчання, больцманове правило навчання, контрастове розходження, неспання — сон[en], варіаційне висновування[en], максимальну правдоподібність, максимальне апостеріорне, ґіббзове вибирання[en] та зворотне поширення похибок відтворення або перепараметрування прихованого стану. Докладніше див. таблицю нижче.

Функція енергії (англ. energy function) — це макроскопічна міра стану збудження мережі. У машинах Больцмана вона виконує роль функції витрат (англ. cost function). Ця аналогія з фізикою натхнена аналізом макроскопічної енергії газу Людвіга Больцмана на основі мікроскопічних імовірностей руху частинок. , де k — стала Больцмана, а T — температура. У мережі ОМБ цим відношенням є ,[9] де та пробігають всі можливі схеми (англ. pattern) збудження, а . Якщо точніше, , де — схема збудження всіх нейронів (видимих і прихованих). Тому ранні нейронні мережі носять назву «машина Больцмана» (англ. Boltzmann machine). Пол Смоленський називає гармонією (англ. Harmony). Мережа шукає низьку енергію, що є високою гармонією.

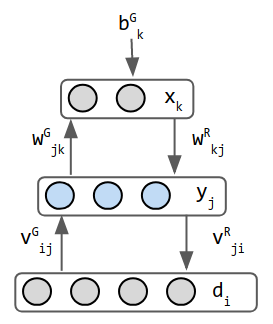

У цій таблиці наведено схеми зв'язності різних некерованих мереж, деталі яких буде наведено в розділі Порівняння мереж. Кола — це нейрони, а ребра між ними — це ваги з'єднань. Зі зміною конструкції мереж функції додаються, щоби відкрити нові можливості, або усуваються, щоби пришвидшити навчання. Наприклад, нейрони змінюються між детермінованими (Гопфілда) та стохастичними (Больцмана), щоби забезпечити робастний вихід, ваги усуваються в межах шару (ОМБ), щоби прискорити навчання, або з'єднанням дозволяється стати асиметричними (Гельмгольца).

| Гопфілда | Больцмана | ОМБ | Складена Больцмана |

|---|---|---|---|

|

|

|

|

| Гельмгольца[en] | Автокодувальник | ВАК |

|---|---|---|

|

|

|

З-поміж людей, чиїми іменами названо ці мережі, безпосередньо з нейронними мережами працював лише Гопфілд. Больцман та Гельмгольц були раніше за створення штучних нейронних мереж, але їхні роботи в галузі фізики та фізіології надихнули використані аналітичні методи.

| 1969 рік | Книга «Перцептрони[en]» Мінського та Пейперта показує, що перцептрон без прихованих шарів неспроможний на виключне «або» |

| 1970-ті роки | (дати приблизні) Перша зима ШІ |

| 1974 рік | Магнітна модель Ізінга запропонована В. А. Літлом[de] для пізнавання |

| 1980 рік | Фукусіма представляє неокогнітрон, який пізніше назвали згортковою нейронною мережею. Його переважно використовують у керованім навчанні, але він заслуговує на згадку й тут. |

| 1982 рік | Видозміну Ізінга, мережу Гопфілда, описано Джоном Гопфілдом як асоціативну пам'ять і класифікатори. |

| 1983 рік | Видозміну Ізінга, машину Больцмана з імовірнісними нейронами, описано Гінтоном і Сейновським[en] по слідах праці Шерінгтона та Кіркпатріка 1975 року. |

| 1986 рік | Пол Смоленський[en] публікує «Теорію гармонії», яка є ОМБ з практично тією ж больцмановою функцією енергії. Смоленський не надав практичної схеми тренування. Гінтон зробив це в середині 2000-х. |

| 1995 рік | Шмідхубер представляє нейрон ДКЧП для мов. |

| 1995 рік | Даян та Гінтон представляють машину Гельмгольца |

| 1995-2005 роки | (дати приблизні) Дуга зима ШІ |

| 2013 рік | Кінгма, Резенде й інші представили варіаційні автокодувальники як баєсову графову ймовірнісну мережу з нейронними мережами як складовими. |

Тут ми висвітлюємо деякі характеристики обраних мереж. Подробиці щодо кожної наведено в порівняльній таблиці нижче.

- Мережа Гопфілда

- Мережі Гопфілда надихнув феромагнетизм. Нейрон відповідає домену заліза з бінарними магнітними моментами Вгору та Донизу, а з'єднання нейронів відповідають впливам доменів один на одного. Симетричні з’єднання уможливлюють формулювання глобальної енергії. Під час висновування мережа уточнює кожен стан використовуючи стандартну функцію кроку збудження. Симетричні ваги та правильні функції енергії гарантують збіжність до стабільного візерунку збудження. Асиметричні ваги аналізувати складно. Мережі Гопфілда використовують як асоціативну пам’ять.

- Машина Больцмана

- Це стохастичні мережі Гопфілда. Значення їхнього стану вибирається з цієї функції густини ймовірності таким чином: припустімо, що бінарний нейрон спрацьовує з імовірністю Бернуллі p(1) = 1/3 і зупиняється з p(0) = 2/3. З цього роблять вибірку, беручи рівномірно розподілене випадкове число y та підставляючи його до оберненої функції розподілу ймовірності, що в даному випадку є відтинково сталою функцією з порогом 2/3. Обернена функція = { 0 якщо x <= 2/3, 1 якщо x > 2/3 }.

- Сигмоїдна мережа переконань

- Представлена Редфордом Нілом 1992 року, ця мережа застосовує ідеї ймовірнісних графових моделей до нейронних мереж. Ключова відмінність полягає в тому, що вузли в графових моделях мають заздалегідь призначені значення, тоді як ознаки нейронів мережі переконань визначаються після тренування. Мережа являє собою розріджено зв’язаний орієнтований ациклічний граф, що складається з бінарних стохастичних нейронів. Правило навчання походить від максимальної правдоподібності на p(X): Δwij sj * (si - pi), де pi = 1 / ( 1 + eзважені входи до нейрону i). sj це збудження з незміщеної вибірки апостеріорного розподілу, і це проблематично через проблему редукції причини (англ. Explaining Away), порушену Джудою Перлом. Варіаційні баєсові методи[en] використовують сурогатне апостеріорне й відверто ігнорують цю складність.

- Глибока мережа переконань

- Ця мережа, представлена Гінтоном, є гібридом ОМБ та сигмоїдної мережі переконань. Верхні 2 шари — це ОМБ, а другий шар униз утворює сигмоїдну мережу переконань. Її тренують методом складеної ОМБ, а потім відкидають ваги розпізнавання під верхньою ОМБ. Станом на 2009 рік оптимальною глибиною видавалися 3—4 шари.[10]

- Машина Гельмгольца

- Це перші джерела натхнення варіаційних автокодувальників. Це 2 мережі, об’єднані в одну: прямі ваги забезпечують розпізнавання, а зворотні втілюють уявляння. Можливо, це перша мережа, яка робила і те, й інше. Гельмгольц не працював у сфері машинного навчання, але він надихнув думку про «механізм статистичного висновування, функцією якого є висновувати ймовірні причини сенсо́рного входу».[11] Стохастичний бінарний нейрон видає ймовірність того, що його стан дорівнює 0 або 1. Вхідні дані зазвичай не вважають шаром, але в породжувальному режимі машини Гельмгольца шар даних отримує вхідні дані від середнього шару й має для цієї мети окремі ваги, тож його вважають шаром. Отже, ця мережа має 3 шари.

- Варіаційний автокодувальник

- Вони натхнені машинами Гельмгольца та поєднують імовірнісну мережу з нейронними мережами. Автокодувальник — це 3-шарова мережа асоціативної пам'яті, де середній шар має бути деяким внутрішнім поданням образів входу. Нейронна мережа кодувальника — це розподіл імовірностей qφ(z коли x), а мережа декодувальника — pθ(x коли z). Ваги називають фі та тета, а не W та V, як у Гельмгольца, — косметична відмінність. Ці 2 мережі тут можуть бути повністю з’єднаними, або використовувати іншу нейромережну схему.

| Гопфілда | Больцмана | ОМБ | Складена ОМБ | Гельмгольца | Автокодувальник | ВАК | |

|---|---|---|---|---|---|---|---|

| Використання й видатні застосування | Асоціативна пам'ять, задача комівояжера | Асоціативна пам'ять. Свобода з'єднань ускладнює аналіз цієї мережі. | розпізнавання образів. використовували в цифрах MNIST та мовленні. | розпізнавання та уявляння. тренується некерованим попереднім тренуванням та/або керованим тонким настроюванням. | уявляння, імітування | мова: творче написання, переклад. бачення: покращування розмитих зображень | породжування реалістичних даних |

| Нейрон | детермінований бінарний стан. Збудження = { 0 (або -1), якщо x від'ємне, 1 в іншому випадку } | стохастичний бінарний нейрон Гопфілда | ← те саме. (розширено до дійснозначних у середині 2000-х) | ← те саме | ← те саме | мова: ДКЧП. зір: локальні рецептивні поля. зазвичай дійснозначне випрямлячеве збудження. | нейрони середнього шару кодують середні значення та дисперсії для гауссіанів. У режимі виконання (висновування) вихід середнього шару є вибірковими значеннями з цих гауссіанів. |

| З'єднання | 1 шар із симетричними вагами. Без самоз'єднань. | 2 шари. 1 прихований та 1 видимий. симетричні ваги. | ← те саме. бічних зв'язків усередині шару немає. |

верхній шар неорієнтований, симетричний. інші шари двобічні, асиметричні. | 3 шари: асиметричні ваги. 2 мережі об'єднано в 1. | 3 шари. Вхід вважають шаром, навіть попри відсутність вхідних ваг. рекурентні шари для ОПМ. згортки прямого поширення для бачення. вхід і вихід мають однакову кількість нейронів. | 3 шари: вхід, кодувальник, декодувальник вибірки з розподілів. вибірку не вважають шаром |

| Висновування й енергія | Енергію задано ґіббзовою ймовірнісною мірою: | ← те саме | ← те саме | мінімізувати КЛ-розходження | висновування лише пряме. попередні мережі некерованого навчання працювали в обох напрямках | мінімізація похибки = похибка відбудови - РКЛ | |

| Тренування | Δwij = si*sj для нейрона +1/-1 | Δwij = e*(pij − p'ij). Це виведено з мінімізування РКЛ. e = темп навчання, p' = передбачений, а p = фактичний розподіл. | Δwij = e*(< vi hj > даних − < vi hj > рівноваги). Це вигляд контрастового розходження з вибіркою за Ґіббзом. «<>» — математичні сподівання. | ← подібне. тренувати 1 шар за раз. наближений стан рівноваги з 3-сегментним проходом. зворотного поширення немає. | 2-фазове навчання неспання-сон | зворотне поширення похибки відбудови | перепараметрувати прихований стан для зворотного поширення |

| Сила | нагадує фізичні системи, бо успадковує їхні рівняння | ← те саме. приховані нейрони діють як внутрішнє подання зовнішнього світу | швидша й практичніша схема тренування, ніж у машин Больцмана | тренується швидко. дає ієрархічний шар ознак | помірно анатомічна. піддається аналізу за допомогою теорії інформації та статистичної механіки | ||

| Слабкість | важко тренувати через бічні з'єднання | рівновага вимагає забагато ітерацій | цілочислові й дійснозначні нейрони складніші. |

Класичним прикладом некерованого навчання у дослідженні нейронних мереж є принцип Дональда Гебба, а саме, що нейрони, які спрацьовують разом, з'єднуються докупи.[12] У геббовім навчанні з'єднання зміцнюється незалежно від помилки, і є виключно функцією збігу потенціалів дії двох нейронів.[13] Подібна версія, яка змінює синаптичні ваги, враховує час між потенціалами дії (спайкова час-залежна пластичність[en],[14][15] або англ. STDP). За припущеннями, геббове навчання лежить в основі низки когнітивних функцій, таких як розпізнавання образів та експериментальне навчання.

Серед нейромережних моделей, в алгоритмах некерованого навчання широко використовують самоорганізаційну карту (СОК, англ. SOM) та теорію адаптивного резонансу[en] (ТАР, англ. ART). СОК — це топографічне впорядкування, в якому сусідні місця на карті подають входи з подібними властивостями. Модель ТАР дозволяє кількості кластерів змінюватися з розміром задачі та дозволяє користувачеві контролювати ступінь подібності між членами одних і тих же кластерів за допомогою визначаної користувачем сталої, званої параметром пильності (англ. vigilance parameter). Мережі ТАР використовують для багатьох завдань розпізнавання образів, таких як автоматичне розпізнавання цілей та обробка сейсмічних сигналів.[16]

Двома основними методами, які використовують у некерованім навчанні, є метод головних компонент і кластерний аналіз. Кластерний аналіз використовують у некерованім навчанні для групування, або сегментування, наборів даних зі спільними атрибутами з метою екстраполювання алгоритмічних зв'язків.[17] Кластерний аналіз — це розділ машинного навчання, який групує дані, які не було мічено[en], класифіковано чи категоризовано. Замість того, щоби реагувати на зворотний зв'язок, кластерний аналіз встановлює спільні риси в даних і реагує залежно від наявності або відсутності таких спільних рис у кожному новому примірнику даних. Цей підхід допомагає виявляти аномальні точки даних, які не допасовуються до жодної з груп.

Основним застосуванням некерованого навчання є оцінювання густини у статистиці,[18] хоча некероване навчання охоплює багато інших областей, включно з узагальнюванням та пояснюванням ознак даних. Його можливо порівняти з керованим навчанням, сказавши, що тоді як кероване навчання має на меті виснувати умовний розподіл імовірності, обумовлений міткою вхідних даних; некероване навчання має на меті виснувати апріорний розподіл імовірності.

До деяких із найпоширеніших алгоритмів, які використовують у некерованім навчанні, належать: (1) кластерування, (2) виявляння аномалій, (3) підходи до навчання моделей з латентними змінними. Кожен підхід використовує декілька методів, а саме:

- До методів кластерування належать: ієрархічне кластерування,[19] k-середні,[20] сумішеві моделі[en], алгоритми DBSCAN та OPTICS

- До методів виявляння аномалій належать коефіцієнт локального відхилення та ізоляційний ліс[en]

- Підходи до навчання моделей з латентними змінними[en] такі як алгоритм очікування-максимізації (англ. EM), метод моментів і методи сліпого виокремлювання сигналу[en] (метод головних компонент, аналіз незалежних компонент[en], розклад невід'ємних матриць, сингулярний розклад матриць)

Одним зі статистичних підходів до некерованого навчання є метод моментів. У ньому невідомі (цільові) параметри в моделі пов'язані з моментами однієї або кількох випадкових величин, і відтак, ці невідомі параметри можливо оцінювати, виходячи з цих моментів. Моменти зазвичай оцінюють з вибірок емпірично. Основними моментами є моменти першого та другого порядків. Для випадкового вектора моментом першого порядку є вектор середнього значення, а моментом другого порядку є коваріаційна матриця (коли середнє нульове). Моменти вищих порядків зазвичай подають за допомогою тензорів, які є узагальненням матриць до вищих порядків як багатовимірних масивів.

Зокрема, показано ефективність методу моментів у навчанні параметрів моделей з латентними змінними[en]. Це статистичні моделі, де на додачу до спостережуваних змінних також існує набір латентних змінних, що не спостерігаються. Дуже практичним прикладом моделей з латентними змінними у машинному навчанні є тематичне моделювання, яке є статистичною моделлю для породжування слів (спостережуваних змінних) у документі на основі теми (латентної змінної) документа. У тематичному моделюванні слова в документі породжуються відповідно до відмінних статистичних параметрів, коли змінюється тема документа. Показано, що метод моментів (методики тензорного розкладу) дозволяє послідовно отримувати параметри великого класу моделей з латентними змінними за деяких припущень.[21]

Алгоритм очікування-максимізації (англ. EM) також є одним із найпрактичніших методів навчання моделей з латентними змінними. Проте він може застрягати в локальних оптимумах, і немає гарантії, що алгоритм збігатиметься до справжніх невідомих параметрів моделі. На відміну від нього, для методу моментів глобальна збіжність за певних умов гарантована.

- Автоматизоване машинне навчання

- Кластерний аналіз

- Виявляння аномалій

- Алгоритм очікування-максимізації

- Породжувальна топографічна карта[en]

- Метанавчання (інформатика)

- Багатовимірний аналіз

- Мережа радіальних базисних функцій

- Слабке керування

- ↑ Синєглазов, Віктор; Чумаченко, Олена (2022). Бідюк, П. І.; Шугалей, Л. П. (ред.). Методи та технології напівкерованого навчання: Курс лекцій (PDF) (укр.). Київ: НТУУ «КПІ ім. Ігоря Сікорського».

- ↑ Дуда, О. М.; Кунанець, Н. Е.; Мацюк, О. В.; Пасічник, В. В. (21—27 травня 2018). Методи аналітичного опрацювання big data (PDF). Інтелектуальні системи прийняття рішень та проблеми обчислювального інтелекту (укр.). Залізний Порт. с. 159. ISBN 978-617-7573-17-2.

- ↑ В'юненко, О. Б.; Виганяйло, С. М. (12 травня 2021). Сокуренко, В. В.; Швець, Д. В.; Могілевський, Л. В.; Шульга, В. П.; Яковлєв, Р. П.; Шмельов, Ю. М. (ред.). Інновації та загальні проблеми підвищення рівня кібербезпеки (PDF). II Міжнародна науково-практична конференція «Авіація, промисловість, суспільство» (укр.). Т. 1. МВС України, Харківський національний університет внутрішніх справ, Кременчуцький льотний коледж. с. 169. ISBN 978-966-610-243-3.

- ↑ Кропивницька, В. Б.; Магас, Д. М. (30 квітня 2023). Напівкероване машинне навчання для виявлення несправностей нафтогазопроводів. Modern engineering and innovative technologies (укр.). 1 (18): 33—36. doi:10.30890/2567-5273.2023-26-01-010.

- ↑ Мальцев, А. Ю. (2021). Огляд принципів глибокого навчання як динамічної теорії штучного інтелекту (PDF). Вчені записки Таврійського національного університету імені В.І. Вернадського (укр.). ТНУ ім. Вернадського. 32 (71). doi:10.32838/2663-5941/2021.6/16. ISSN 2663-5941.

- ↑ Мельник, А.; Берестенко, Д. (2022). Дослідження методів машинного навчання (PDF). Автоматика, комп’ютерно-інтегровані технології та проблеми енергоефективності в промисловості і сільському господарстві (АКІТ-2022) (укр.). Кропивницький: КНТУ. с. 41—42.

- ↑ Іваніченко, Є.; Сабліна, М.; Кравчук, К. (2021). Використання машинного навчання в кібербезпеці. Кібербезпека: освіта, наука, техніка» (укр.). 4 (12): 32—142.

- ↑ Лавренюк, М. С.; Новіков, О. М. (2018). Огляд методів машинного навчання для класифікації великих обсягів супутникових даних. Системні дослідження та інформаційні технології (укр.) (1): 52—71. doi:10.20535/SRIT.2308-8893.2018.1.04.

- ↑ Hinton, G. (2012). A Practical Guide to Training Restricted Boltzmann Machines (PDF). Neural Networks: Tricks of the Trade. Lecture Notes in Computer Science (англ.). Т. 7700. Springer. с. 599—619. doi:10.1007/978-3-642-35289-8_32. ISBN 978-3-642-35289-8.

- ↑ Hinton, Geoffrey (September 2009). Deep Belief Nets (video) (англ.).

- ↑ Peter, Dayan; Hinton, Geoffrey E.; Neal, Radford M.; Zemel, Richard S. (1995). The Helmholtz machine. Neural Computation (англ.). 7 (5): 889—904. doi:10.1162/neco.1995.7.5.889. hdl:21.11116/0000-0002-D6D3-E. PMID 7584891. S2CID 1890561.

- ↑ Buhmann, J.; Kuhnel, H. (1992). Unsupervised and supervised data clustering with competitive neural networks. [Proceedings 1992] IJCNN International Joint Conference on Neural Networks (англ.). Т. 4. IEEE. с. 796—801. doi:10.1109/ijcnn.1992.227220. ISBN 0780305590. S2CID 62651220.

- ↑ Comesaña-Campos, Alberto; Bouza-Rodríguez, José Benito (June 2016). An application of Hebbian learning in the design process decision-making. Journal of Intelligent Manufacturing (англ.). 27 (3): 487—506. doi:10.1007/s10845-014-0881-z. ISSN 0956-5515. S2CID 207171436.

- ↑ Чернетченко, Д.; Мілих, М.; Луданов, К. (2019). Апаратна реалізація імпульсної штучної нейронної мережі для детектування параметрів електрокардіографічного сигналу (ЕКГ) (PDF). Вісник Херсонського національного технічного університету (укр.). 4 (275): 126—133. doi:10.31891/2307-5732. ISSN 2307-5732. Процитовано 10 серпня 2023.

- ↑ Чернетченко, Д. В. (2019). Метод та апаратно-програмний засіб обробки електрокардіографічних сигналів за допомогою штучних мультистабільних нейронних мереж (автореферат дисертації на здобуття наукового ступеня кандидата технічних наук) (укр.). Вінниця: ВНТУ. Процитовано 10 серпня 2023.

- ↑ Carpenter, G.A. & Grossberg, S. (1988). The ART of adaptive pattern recognition by a self-organizing neural network (PDF). Computer (англ.). 21 (3): 77—88. doi:10.1109/2.33. S2CID 14625094. Архів оригіналу (PDF) за 16 травня 2018. Процитовано 11 серпня 2023.

- ↑ Roman, Victor (21 квітня 2019). Unsupervised Machine Learning: Clustering Analysis. Medium (англ.). Процитовано 1 жовтня 2019.

- ↑ Jordan, Michael I.; Bishop, Christopher M. (2004). 7. Intelligent Systems §Neural Networks. У Tucker, Allen B. (ред.). Computer Science Handbook (англ.) (вид. 2nd). Chapman & Hall/CRC Press. doi:10.1201/9780203494455. ISBN 1-58488-360-X.

- ↑ Hastie, Tibshirani та Friedman, 2009, с. 485—586

- ↑ Garbade, Dr Michael J. (12 вересня 2018). Understanding K-means Clustering in Machine Learning. Medium (англ.). Процитовано 31 жовтня 2019.

- ↑ Anandkumar, Animashree; Ge, Rong; Hsu, Daniel; Kakade, Sham; Telgarsky, Matus (2014). Tensor Decompositions for Learning Latent Variable Models (PDF). Journal of Machine Learning Research (англ.). 15: 2773—2832. arXiv:1210.7559. Bibcode:2012arXiv1210.7559A.

- Bousquet, O.; von Luxburg, U.; Raetsch, G., ред. (2004). Advanced Lectures on Machine Learning (англ.). Springer. ISBN 978-3540231226.

- Duda, Richard O.; Hart, Peter E.; Stork, David G. (2001). Unsupervised Learning and Clustering. Pattern classification (англ.) (вид. 2nd). Wiley. ISBN 0-471-05669-3.

- Hastie, Trevor; Tibshirani, Robert; Friedman, Jerome (2009). Unsupervised Learning. The Elements of Statistical Learning: Data mining, Inference, and Prediction (англ.). Springer. с. 485—586. doi:10.1007/978-0-387-84858-7_14. ISBN 978-0-387-84857-0.

- Hinton, Geoffrey; Sejnowski, Terrence J., ред. (1999). Unsupervised Learning: Foundations of Neural Computation (англ.). MIT Press. ISBN 0-262-58168-X.